ディープネットワークによる

シーンの大域的かつ局所的な整合性を考慮した画像補完

|

|

|

|

|

|

|

|

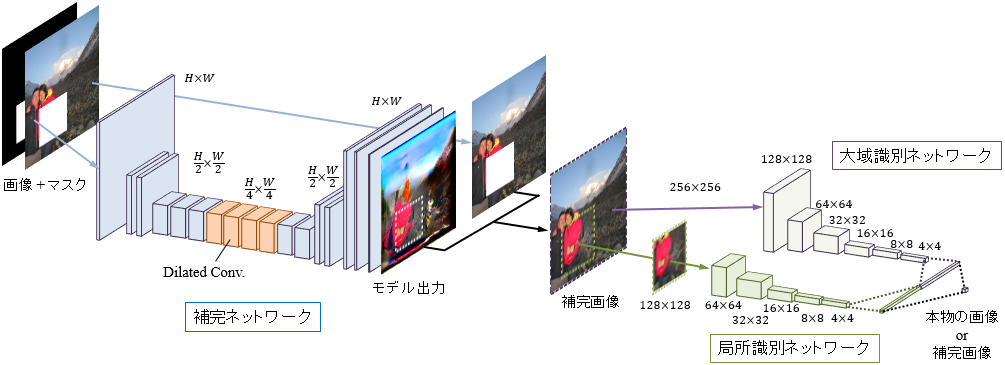

本研究では,畳み込みニューラルネットワークを用いて,シーンの大域的かつ局所的な整合性を考慮した画像補完を行う手法を提案する.提案する補完ネットワークは全層が畳み込み層で構成され,任意のサイズの画像における自由な形状の「穴」を補完できる.この補完ネットワークに,シーンの整合性を考慮した画像補完を学習させるため,本物の画像と補完された画像を識別するための大域識別ネットワークと局所識別ネットワークを構築する.大域識別ネットワークは画像全体が自然な画像になっているかを評価し,局所識別ネットワークは補完領域周辺のより詳細な整合性によって画像を評価する.この2つの識別ネットワーク両方を「だます」ように補完ネットワークを学習させることで,シーン全体で整合性が取れており,かつ局所的にも自然な補完画像を出力することができる.提案手法により,様々なシーンにおいて自然な画像補完が可能となり,さらに従来のパッチベースの手法ではできなかった,入力画像に写っていないテクスチャや物体を新たに生成することもできる.これにより,人間の顔の一部を補完するような,複雑な画像補完を実現した.

提案モデルは3つのネットワークから構成される.すなわち,補完ネットワーク,大域識別ネットワーク,局所識別ネットワークである.実際の画像補完に使用するのは補完ネットワークのみであり,2つの識別ネットワークは補完ネットワークの学習のために使用される.補完ネットワークはすべての層が畳み込み層で構成され,補完対象の損失領域を定義したマスクと画像が入力されると,損失領域が補完された画像が出力される.損失領域以外の領域は入力画像に置き換えることで,最終的な補完画像が得られる.大域識別ネットワークは補完された画像全体を入力とし,補完画像が全体的に整合性のある構造になっているかを評価する.局所識別ネットワークは補完領域をパッチとして切り出して入力とし,補完領域のより詳細な自然さを評価する.補完ネットワークは識別ネットワークが見分けられないように,識別ネットワークは補完ネットワークの出力画像を見抜くように,それぞれのネットワークを交互に学習していくことで補完ネットワークに自然な画像補完を学習させている.

4つの関連手法との比較.補完する「穴」はランダムに生成している.

@Article{IizukaSIGGRAPH2017,

author =

{Satoshi Iizuka and Edgar Simo-Serra and Hiroshi Ishikawa},

title = {{Globally and Locally Consistent Image Completion}},

journal = "ACM Transactions on Graphics

(Proc. of SIGGRAPH 2017)",

year = 2017,

volume = 36,

number = 4,

pages = 107:1--107:14,

articleno = 107,

} This work was partially supported by JST ACT-I Grant Number JPMJPR16U3 and JST CREST Grant Number JPMJCR14D1.